GreenLake Memasuki Pasar AI Dengan Layanan LLM Cloud

Penawaran cloud baru harus 100% netral karbon dan akan berjalan di superkomputer Cray, kata HPE.

Layanan cloud superkomputer baru GreenLake for Massive Language Fashions akan tersedia pada akhir 2023 atau awal 2024 di AS, Hewlett Packard Enterprise mengumumkan di HPE Uncover pada hari Selasa. GreenLake untuk LLM akan memungkinkan perusahaan untuk melatih, menyetel, dan menerapkan kecerdasan buatan skala besar yang bersifat pribadi untuk setiap bisnis individu.

GreenLake untuk LLM akan tersedia untuk pelanggan Eropa setelah rilis di AS, dengan jendela rilis yang diantisipasi pada awal 2024.

Lompat ke:

HPE bermitra dengan startup perangkat lunak AI Aleph Alpha

“AI berada pada titik belok, dan di HPE kami melihat permintaan dari berbagai pelanggan mulai memanfaatkan AI generatif,” kata Justin Hotard, wakil presiden eksekutif dan manajer umum untuk Grup Bisnis HPC & AI dan Lab Hewlett Packard, dalam presentasi digital .

GreenLake untuk LLM berjalan pada arsitektur asli AI yang mencakup ratusan atau ribuan CPU atau GPU, bergantung pada beban kerjanya. Fleksibilitas dalam satu penawaran arsitektur AI-native membuatnya lebih efisien daripada opsi cloud tujuan umum yang menjalankan banyak beban kerja secara paralel, kata HPE. GreenLake untuk LLM dibuat dalam kemitraan dengan Aleph Alpha, startup AI Jerman, yang menyediakan LLM terlatih yang disebut Luminous. Luminous LLM dapat berfungsi dalam bahasa Inggris, Prancis, Jerman, Italia, dan Spanyol serta dapat menggunakan teks dan gambar untuk membuat prediksi.

Kolaborasi berjalan dua arah, dengan Aleph Alpha menggunakan infrastruktur HPE untuk melatih Luminous di tempat pertama.

“Dengan menggunakan superkomputer HPE dan perangkat lunak AI, kami melatih Luminous secara efisien dan cepat,” kata Jonas Andrulis, pendiri dan CEO Aleph Alpha, dalam siaran pers. “Kami bangga menjadi mitra peluncuran HPE GreenLake untuk Mannequin Bahasa Besar, dan kami berharap dapat memperluas kolaborasi kami dengan HPE untuk memperluas Luminous ke cloud dan menawarkannya sebagai layanan kepada pelanggan akhir kami untuk mendorong aplikasi baru untuk inisiatif bisnis dan penelitian.”

Peluncuran awal akan mencakup satu set mannequin open-source dan proprietary untuk pelatihan ulang atau fine-tuning. Di masa mendatang, HPE berharap dapat menyediakan AI khusus untuk tugas-tugas yang berkaitan dengan pemodelan iklim, perawatan kesehatan, keuangan, manufaktur, dan transportasi.

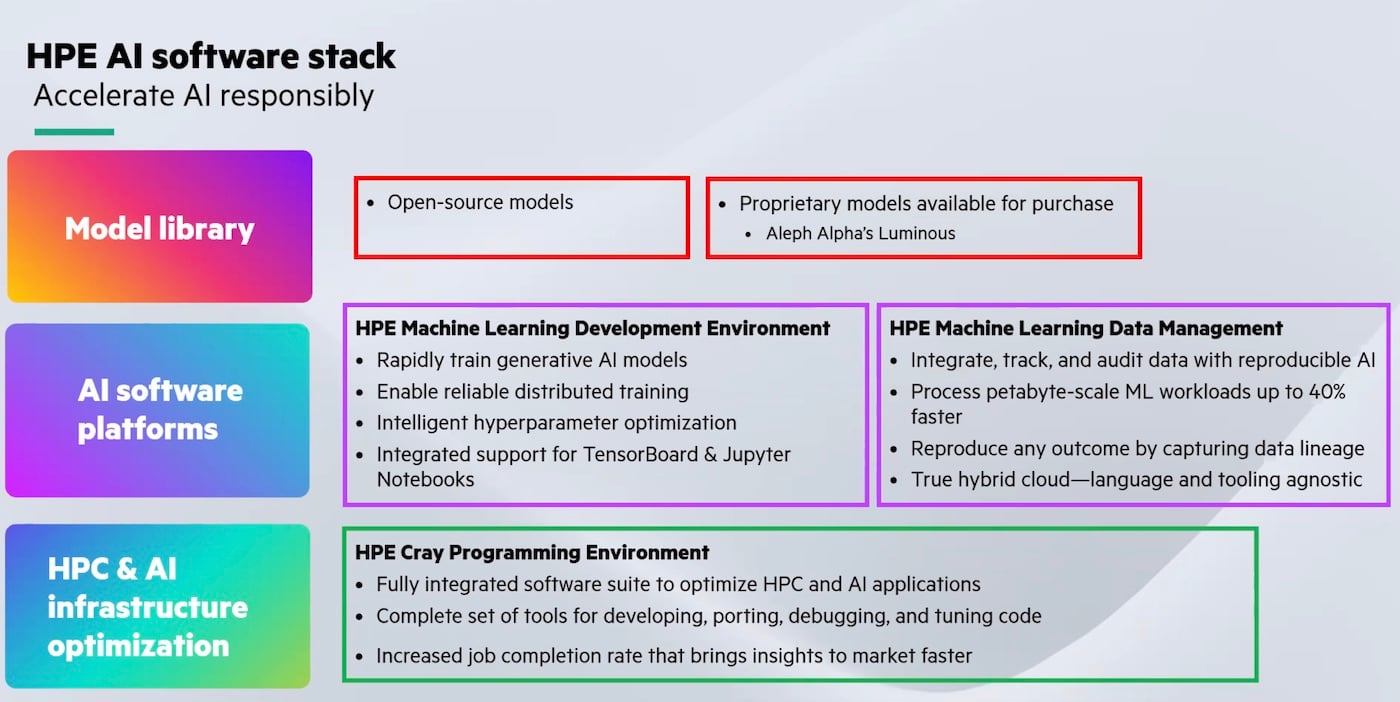

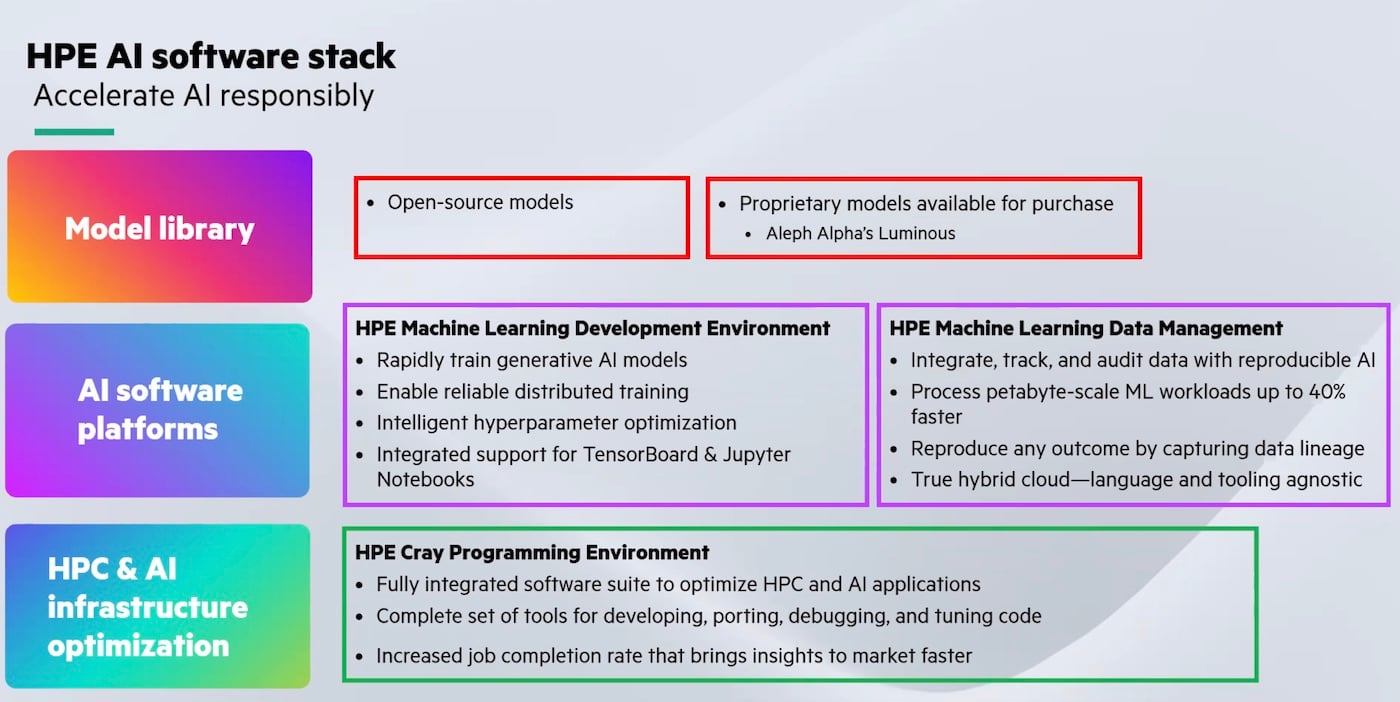

Untuk saat ini, GreenLake untuk LLM akan menjadi bagian dari tumpukan perangkat lunak AI HPE secara keseluruhan (Gambar A), yang mencakup mannequin Luminous, pengembangan pembelajaran mesin, pengelolaan information dan program pengembangan, dan lingkungan pemrograman Cray.

Gambar A

Superkomputer Cray XD HPE memungkinkan kinerja AI perusahaan

GreenLake untuk LLM berjalan pada superkomputer Cray XD HPE dan GPU NVIDIA H100. Superkomputer dan Lingkungan Pemrograman HPE Cray memungkinkan pengembang untuk melakukan analitik information, tugas bahasa alami, dan pekerjaan lain pada komputasi bertenaga tinggi dan aplikasi AI tanpa harus menjalankan perangkat keras mereka sendiri, yang dapat mahal dan memerlukan keahlian khusus untuk superkomputer.

Produksi perusahaan skala besar untuk AI membutuhkan sumber daya kinerja yang besar, orang-orang yang terampil, serta keamanan dan kepercayaan, kata Hotard selama presentasi.

MELIHAT: NVIDIA menawarkan persewaan AI pada superkomputer DGX-nya.

Mendapatkan lebih banyak daya dari energi terbarukan

Dengan menggunakan fasilitas colocation, HPE bertujuan untuk menggerakkan superkomputernya dengan 100% energi terbarukan. HPE bekerja sama dengan spesialis pusat komputasi, QScale, di Amerika Utara pada desain yang dibuat khusus untuk tujuan ini.

“Dalam semua penerapan cloud kami, tujuannya adalah untuk memberikan penawaran netral karbon 100% kepada pelanggan kami,” kata Hotard. “Salah satu manfaat dari pendinginan cair adalah Anda dapat benar-benar mengambil air limbah, air panas, dan menggunakannya kembali. Kami memilikinya di instalasi superkomputer lainnya, dan kami juga memanfaatkan keahlian itu dalam penerapan cloud ini.”

Alternatif untuk HPE GreenLake untuk LLM

Layanan berbasis cloud lainnya untuk menjalankan LLM termasuk NeMo NVIDIA (yang saat ini dalam akses awal), Amazon Bedrock, dan Infrastruktur Cloud Oracle.

Hotard mencatat dalam presentasinya bahwa GreenLake untuk HPE akan menjadi pelengkap, bukan pengganti, layanan cloud besar seperti AWS dan Google Cloud Platform.

“Kami dapat dan bermaksud untuk berintegrasi dengan cloud publik. Kami melihat ini sebagai penawaran free of charge; kami tidak melihat ini sebagai pesaing, ”katanya.