Perangkat Keras Canggih Memangkas Konsumsi Energi AI hingga 1000x

Peneliti Universitas Minnesota telah memperkenalkan inovasi perangkat keras yang disebut CRAM, yang mengurangi penggunaan energi AI hingga 2.500 kali dengan memproses knowledge dalam memori, menjanjikan kemajuan signifikan dalam efisiensi AI.

Perangkat ini dapat memangkas konsumsi energi kecerdasan buatan sedikitnya 1.000 kali lipat.

Para peneliti di bidang teknik di College of Minnesota Twin Cities telah mengembangkan perangkat keras canggih yang dapat mengurangi penggunaan energi di kecerdasan buatan (AI) aplikasi komputasi setidaknya faktor 1.000.

Penelitian ini dipublikasikan di npj Komputasi Non-Konvensionaljurnal ilmiah yang ditinjau sejawat dan diterbitkan oleh Nature. Para peneliti memiliki beberapa paten atas teknologi yang digunakan dalam perangkat tersebut.

Dengan meningkatnya permintaan aplikasi AI, para peneliti telah mencari cara untuk menciptakan proses yang lebih hemat energi, sekaligus menjaga kinerja tetap tinggi dan biaya tetap rendah. Umumnya, proses mesin atau kecerdasan buatan mentransfer knowledge antara logika (tempat informasi diproses dalam suatu sistem) dan memori (tempat knowledge disimpan), yang menghabiskan banyak daya dan energi.

Pengenalan Teknologi CRAM

Sebuah tim peneliti di Fakultas Sains dan Teknik Universitas Minnesota mendemonstrasikan mannequin baru di mana knowledge tidak pernah meninggalkan memori, yang disebut memori akses acak komputasional (CRAM).

“Karya ini adalah demonstrasi eksperimental pertama CRAM, di mana knowledge dapat diproses sepenuhnya dalam susunan memori tanpa perlu meninggalkan jaringan tempat komputer menyimpan informasi,” kata Yang Lv, peneliti pascadoktoral Departemen Teknik Elektro dan Komputer Universitas Minnesota dan penulis pertama makalah tersebut.

Perangkat keras yang dibuat khusus berencana untuk membantu kecerdasan buatan menjadi lebih hemat energi. Kredit: College of Minnesota Twin Cities

Badan Energi Internasional (IEA) mengeluarkan perkiraan penggunaan energi international pada bulan Maret 2024, memperkirakan bahwa konsumsi energi untuk AI kemungkinan akan berlipat ganda dari 460 terawatt-jam (TWh) pada tahun 2022 menjadi 1.000 TWh pada tahun 2026. Ini kira-kira setara dengan konsumsi listrik seluruh negara Jepang.

Menurut penulis makalah baru tersebut, CRAM berbasis pembelajaran mesin akselerator inferensi diperkirakan mencapai peningkatan sebesar 1.000. Contoh lain menunjukkan penghematan energi sebesar 2.500 dan 1.700 kali dibandingkan dengan metode tradisional.

Evolusi Penelitian

Penelitian ini telah berlangsung selama lebih dari dua dekade,

“Konsep awal kami untuk menggunakan sel memori secara langsung untuk komputasi 20 tahun lalu dianggap gila,” kata Jian-Ping Wang, penulis senior makalah tersebut dan seorang Profesor McKnight Terhormat dan Ketua Robert F. Hartmann di Departemen Teknik Elektro dan Komputer di Universitas Minnesota.

“Dengan kelompok mahasiswa yang terus berkembang sejak tahun 2003 dan tim fakultas yang benar-benar interdisipliner yang dibangun di College of Minnesota—dari fisika, ilmu dan rekayasa materials, ilmu dan rekayasa komputer, hingga pemodelan dan pembandingan, dan pembuatan perangkat keras—kami mampu memperoleh hasil positif dan sekarang telah menunjukkan bahwa teknologi semacam ini layak dan siap untuk dimasukkan ke dalam teknologi,” kata Wang.

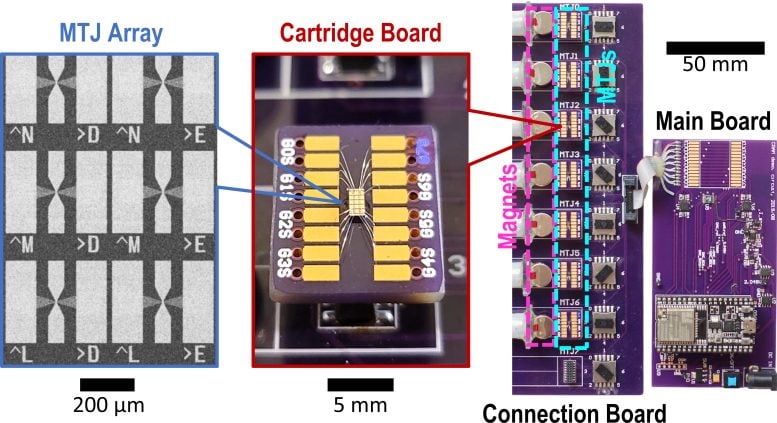

Penelitian ini merupakan bagian dari upaya yang koheren dan berjangka panjang yang dibangun atas penelitian Wang dan para kolaboratornya yang inovatif dan dipatenkan terhadap perangkat Magnetic Tunnel Junctions (MTJ), yang merupakan perangkat berstruktur nano yang digunakan untuk meningkatkan laborious drive, sensor, dan sistem mikroelektronika lainnya, termasuk Magnetic Random Entry Reminiscence (MRAM), yang telah digunakan dalam sistem tertanam seperti mikrokontroler dan jam tangan pintar.

Arsitektur CRAM memungkinkan komputasi sebenarnya di dalam dan oleh memori dan meruntuhkan dinding antara komputasi dan memori sebagai hambatan dalam arsitektur von Neumann tradisional, desain teoritis untuk komputer program tersimpan yang berfungsi sebagai dasar untuk hampir semua komputer fashionable.

“Sebagai substrat komputasi dalam memori berbasis digital yang sangat hemat energi, CRAM sangat fleksibel karena komputasi dapat dilakukan di lokasi mana pun dalam susunan memori. Dengan demikian, kami dapat mengonfigurasi ulang CRAM agar paling sesuai dengan kebutuhan kinerja serangkaian algoritme AI yang beragam,” kata Ulya Karpuzcu, seorang pakar arsitektur komputasi, salah satu penulis makalah tersebut, dan Affiliate Professor di Departemen Teknik Elektro dan Komputer di College of Minnesota. “CRAM lebih hemat energi daripada blok penyusun tradisional untuk sistem AI saat ini.”

CRAM melakukan perhitungan langsung dalam sel memori, memanfaatkan struktur array secara efisien, yang menghilangkan kebutuhan akan switch knowledge yang lambat dan intensif energi, jelas Karpuzcu.

Perangkat memori akses acak jangka pendek, atau RAM, yang paling efisien menggunakan empat atau lima transistor untuk mengodekan angka satu atau nol, tetapi satu MTJ, perangkat spintronik, dapat menjalankan fungsi yang sama dengan sebagian kecil energi, dengan kecepatan lebih tinggi, dan tahan terhadap lingkungan yang keras. Perangkat spintronik memanfaatkan putaran elektron daripada muatan listrik untuk menyimpan knowledge, sehingga memberikan alternatif yang lebih efisien daripada chip berbasis transistor tradisional.

Saat ini, tim tersebut telah merencanakan untuk bekerja dengan para pemimpin industri semikonduktor, termasuk di Minnesota, untuk menyediakan demonstrasi skala besar dan memproduksi perangkat keras guna memajukan fungsionalitas AI.

Referensi: “Demonstrasi eksperimental memori akses acak komputasional berbasis sambungan terowongan magnetik” oleh Yang Lv, Brandon R. Zink, Robert P. Bloom, Hüsrev Cılasun, Pravin Khanal, Salonik Resch, Zamshed Chowdhury, Ali Habiboglu, Weigang Wang, Sachin S. Sapatnekar, Ulya Karpuzcu dan Jian-Ping Wang, 25 Juli 2024, npj Komputasi Non-Konvensional.

Nomor Induk Kependudukan: 10.1038/s44335-024-00003-3

Selain Lv, Wang, dan Karpuzcu, tim tersebut juga mencakup peneliti dari Departemen Teknik Elektro dan Komputer Universitas Minnesota, Robert Bloom dan Husrev Cilasun; Profesor Terhormat McKnight dan Ketua Robert dan Marjorie Henle, Sachin Sapatnekar; dan mantan peneliti pascadoktoral Brandon Zink, Zamshed Chowdhury, dan Salonik Resch; bersama dengan peneliti dari Universitas Arizona: Pravin Khanal, Ali Habiboglu, dan Profesor Weigang Wang.

Pekerjaan ini didukung oleh hibah dari Badan Proyek Penelitian Lanjutan Pertahanan AS (DARPA), Institut Nasional Standar dan Teknologi (NIST), Yayasan Sains Nasional (NSF), dan Cisco Inc. Penelitian termasuk pola nanodevice dilakukan bekerja sama dengan Minnesota Nano Heart dan pekerjaan simulasi/perhitungan dilakukan dengan Minnesota Supercomputing Institute di Universitas Minnesota.